Crear un archivo robots.txt para posicionar un blog es una tarea sencilla y si creías que este archivo no te ayudara en nada estas equivocado. Ya que este archivo es muy importante para los buscadores como Google search o yahoo search, ya que para poder indexar tu web y que esta pueda mostrarse en los resultados de búsqueda los Robots de estas compañías buscan en tu archivo Robots.txt los diferentes parámetros establecidos en donde colocaremos que partes de nuestra web están disponibles para todo el publico o cuales no, ademas le daremos la ubicación exacta de nuestro mapa de sitio.

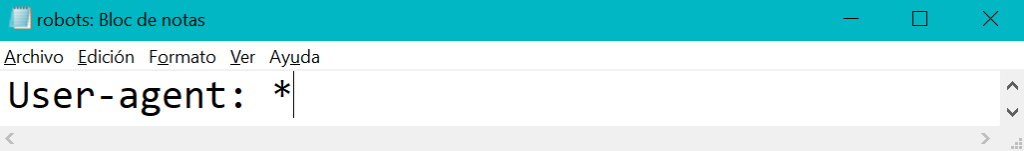

Este archivo lo puedes crear de manera muy sencilla usando el Blog de Notas en Windows o OneNot en Ios. Sin mas vamos a crear nuestro robots.txt para enviarlo a google. Para otorgar permiso de rastreo a los buscadores se utiliza el comando:

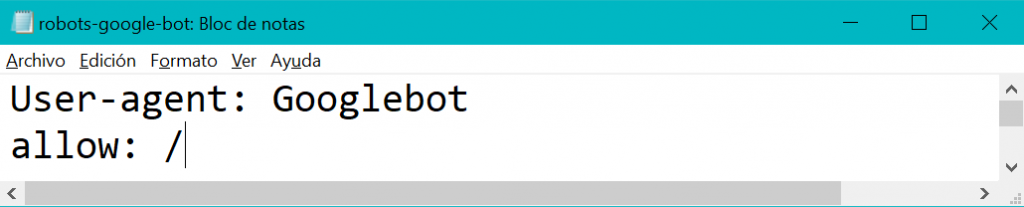

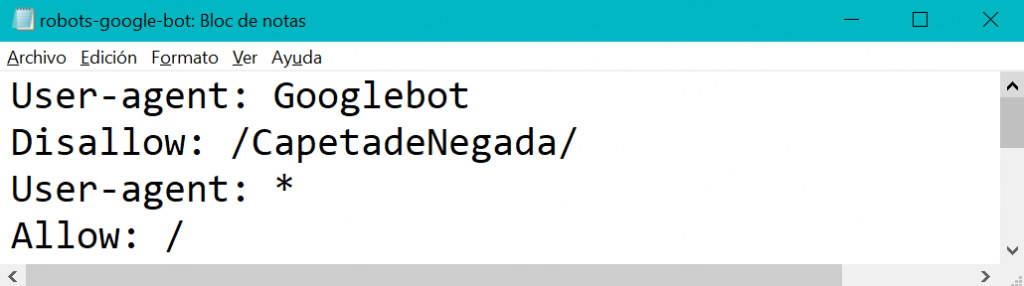

Como todos sabemos en Internet existen infinidad de motores de búsqueda como Google, yahoo, bing, etc. Cada buscador tiene su propio bot o «araña» que rastrear todo el contenido de las paginas web y curiosamente tienen un nombre propio, por ejemplo el robot encargado de rastrear las web en google se llama «Google Bot«.

Si deseas solo permitir acceso a un buscador por ejemplo a google puedes usar la siguiente sentencia:

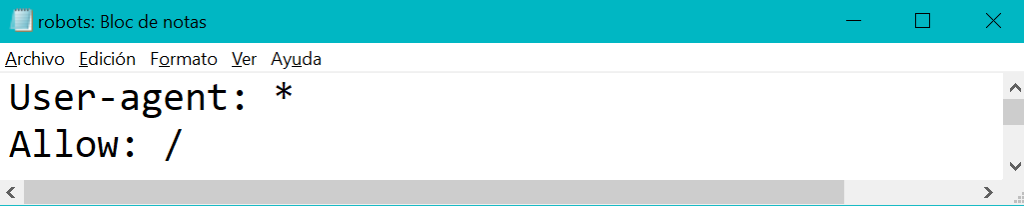

Para otorgar permiso a todo tu contenido y a todas tus carpetas y archivo utiliza la siguiente sentencia:

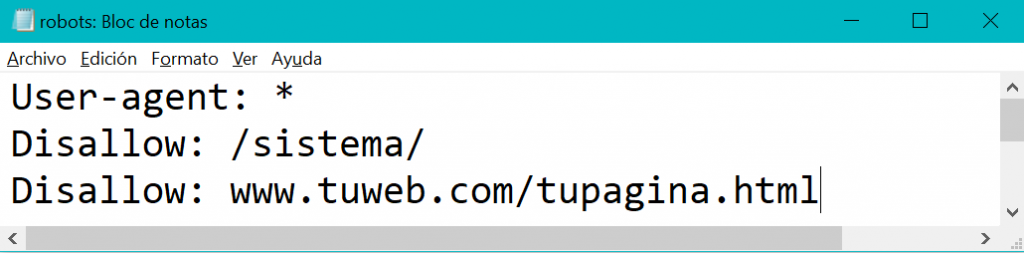

Si tienes una web con área privada para tus usuario registrados es importante especificar que los buscadores no tendrán acceso a los archivos internos, pueden ser carpetas completas o solo archivos individuales, en ambos casos es necesario especificar la url interna de los archivos y carpetas que no quieres que los buscadores rastreen, y se hace de la siguiente manera:

Comprendamos un poco las 3 lineas que ahora contiene nuestro archivo: Estamos indicando con «User-agent: *» que todos los buscadores tendran acceso a nuestro contenido, y especificamos que no podran acceder a la carpeta «Sistema» y tampoco podran rastrear la pagina individual «www.tuweb.com/tupagina.html».

Si dentro de tu web tienes mas carpetas a las cuales deseas que los buscadores no tengan acceso coloca una carpeta por linea. o en su caso una url de pagina especifica por cada linea.

Dentro de tu archivo robot.txt puedes incluir tantos Agentes de búsqueda como lo crear conveniente y otorgar permisos específicos o por el contrario denegarlos, veamos ahora un ejemplo donde negamos el acceso al robot de Google a una carpeta y a los demás robots de otros buscadores si les damos acceso:

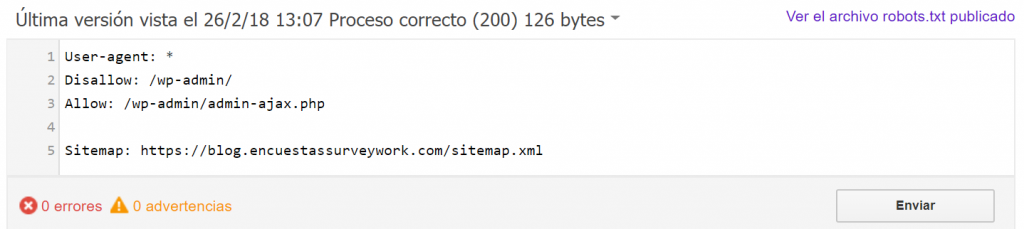

Dentro de tu archivo robots.txt integra la ubicación de tu sitemap, si no sabes como crear este archivo te recomendamos dar lectura a nuestro articulo: Crear un mapa de sitio

Bien ahora que ya tenemos creado nuestro mapa de sitio es hora de integrarlo a nuestro archivo robots.txt y es importante colocarlo al final de nuestro archivo con la siguiente instrucción:

Una vez realizado tu archivo guárdalo con el nombre Robots.txt, la extensión de archivo es muy importante recuerda guardarlo como un archivo .txt. y sube lo a tu hosting, este archivo debe estar disponible en tu carpeta raíz. y tener acceso a el mediante la liga: https://Miblog.com/robots.txt

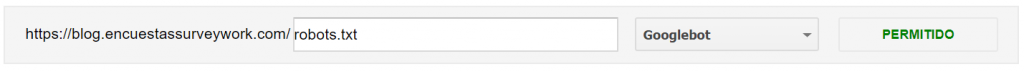

Es hora de indicarle a google que tenemos un archivo Robots.txt configurado y listo para ser rastreado. Es hora de dirigirnos a la plataforma de google search console. Si aun no integras tu blog o web a google web master en este articulo te explicamos como hacerlo: Integrar nuestro blog o web a google search console

Enviar robots.txt a google para mejorar la posición de un blog o web

Localiza dentro del menú principal de google webmaster la opción «Rastreo», y en su sub menú «Probador de Robots.txt». Probar para validar que tu archivo no contiene errores, y a continuación da clic en enviar, si sale todo correcto podrás ver el resultado como el siguiente:

Excelente el ultimo paso y el mas sencillo para concluir esta tarea es enviarlo a google, y basta con dar clic en la opción «Enviar»:

Existo señores, ahora hemos enviado nuestro archivo robot con el cual indicamos a google que tenemos configuración y permisos especiales para los buscadores, ademas un punto importante es que google toma mas enserio a las webs o blog que contienen este archivo configurado, así que no olvides crear el tuyo y enviarlo a la brevedad.

Déjanos tu opinión acerca de los archivo robots.txt, ¿te han complicado la vida?